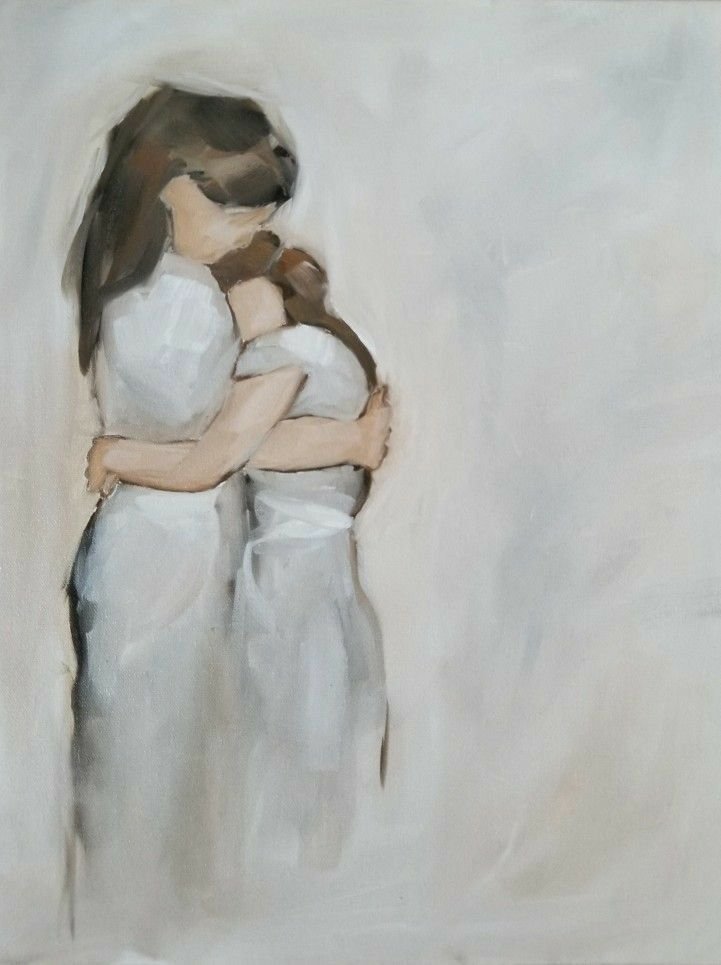

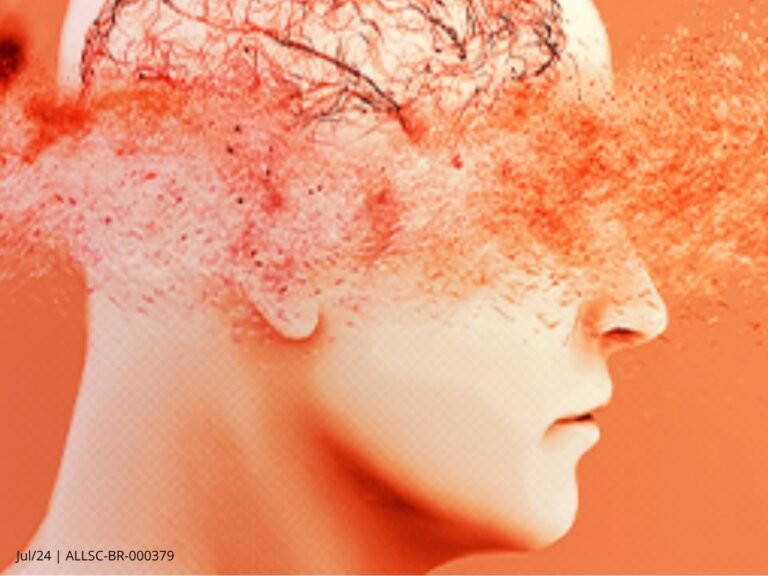

Cada vez mais pessoas usam a inteligência artificial para fazer terapia. Aplicativos e plataformas oferecem atendimentos que imitam conversas com psicólogos. No entanto, especialistas alertam que a prática pode trazer riscos.

Uma pesquisa americana revelou que entre as pessoas que usam IA e afirmam ter algum problema de saúde mental, metade usa robôs como apoio emocional, para desabafar, compartilhar sentimentos e pedir conselhos.

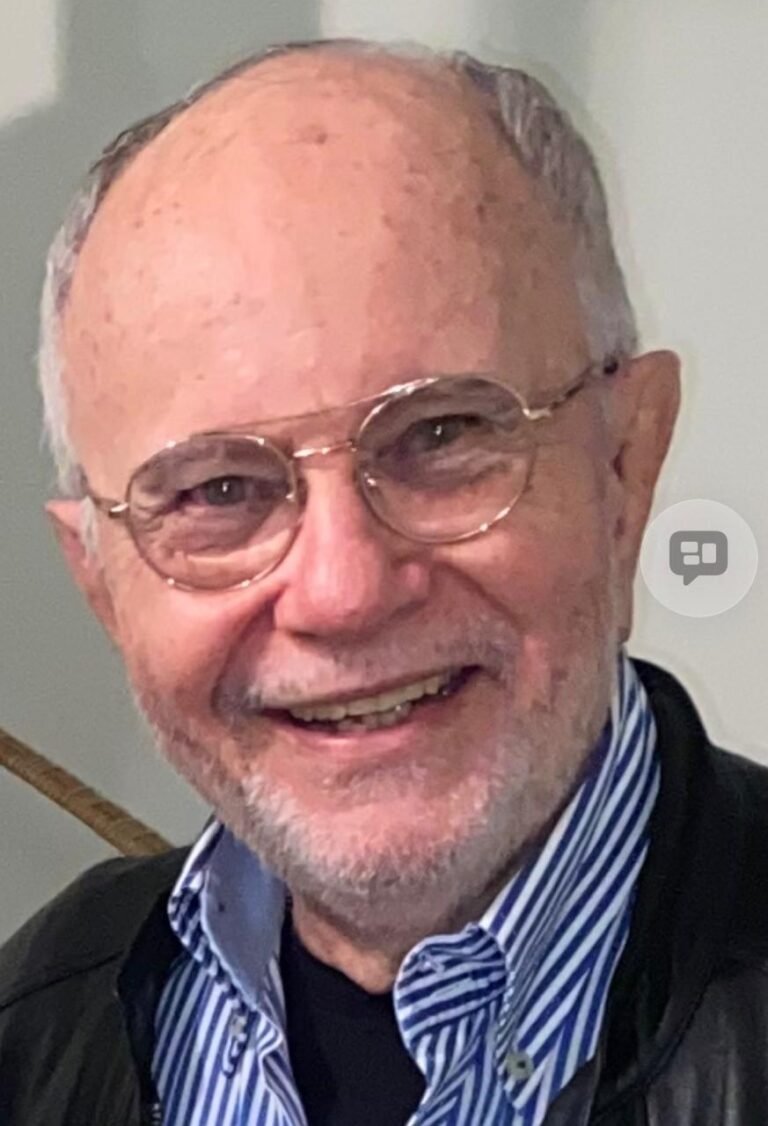

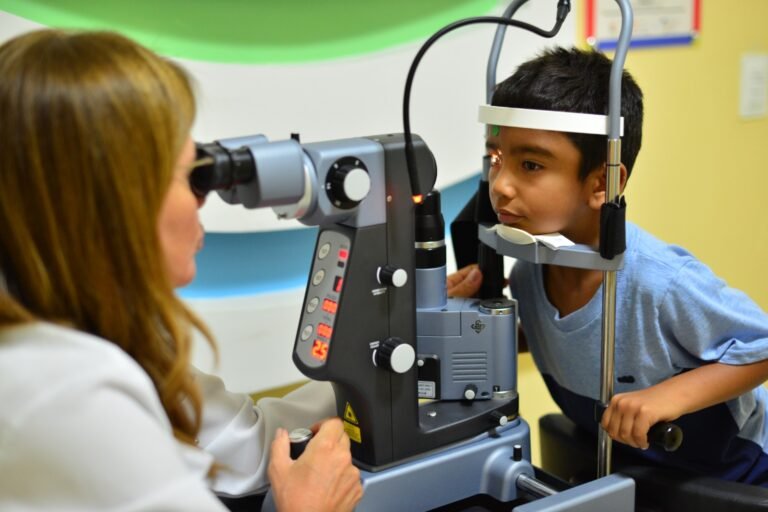

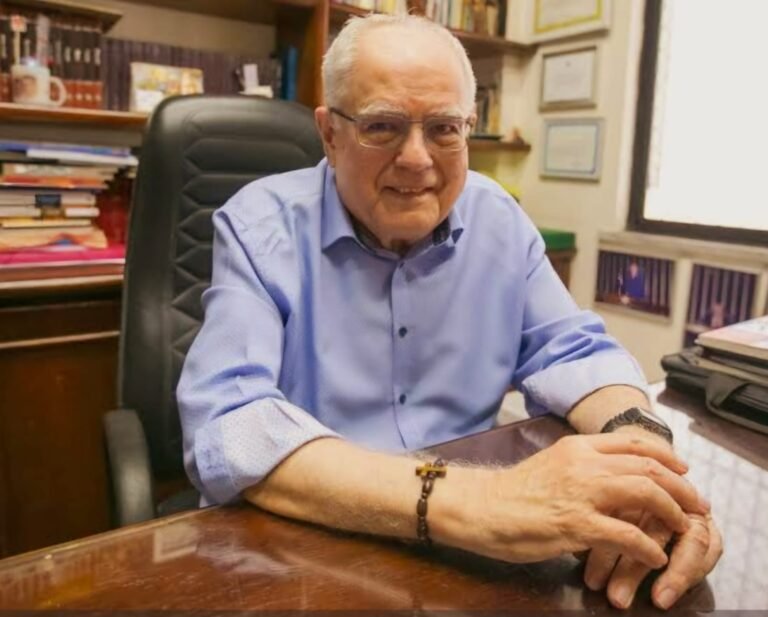

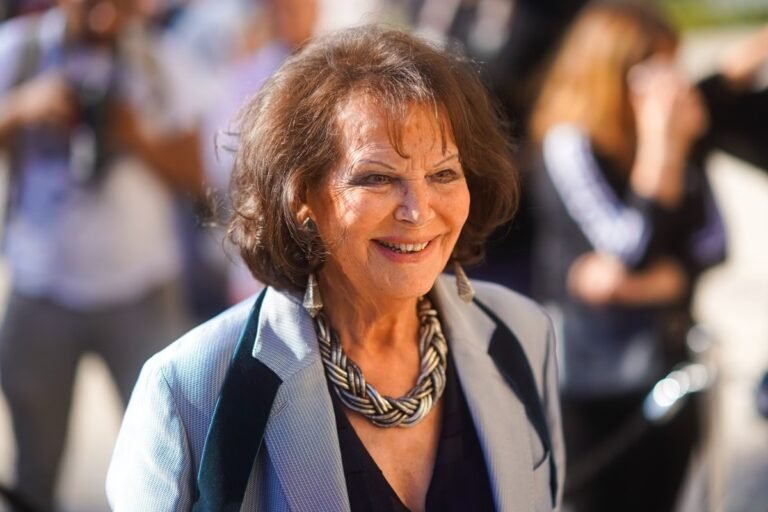

Recentemente, o Fantástico decidiu testar essa tendência. A repórter Renata Ceribelli usou um programa de IA como psicoterapeuta digital, sob a supervisão de um especialista real, o psicanalista e professor da USP, Christian Dunker.

Logo no início, a ferramenta pediu para que ela contasse um pouco sobre sua vida. As respostas eram automáticas, mas formuladas de uma forma que pareceria haver alguém do outro lado.

O teste revelou que a inteligência artificial consegue demonstrar empatia e até sugerir conselhos, o que fez com que Renata se sentisse compreendida em alguns momentos. Mas especialistas destacam que essa sensação pode ser enganosa.

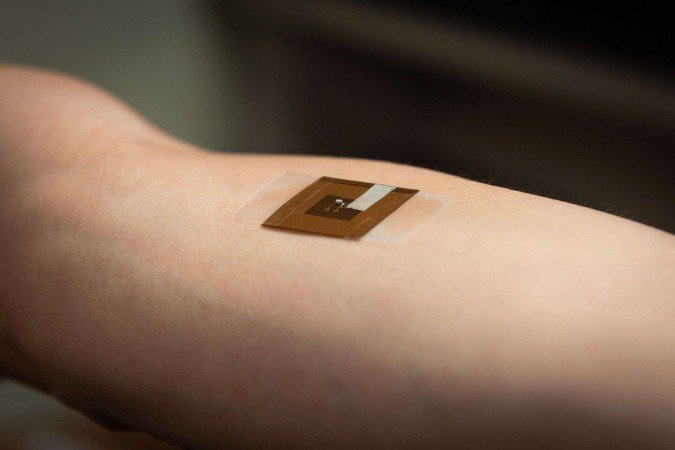

Outro problema é a falta de sigilo. Ao usar aplicativos de IA, informações íntimas podem ser armazenadas e usadas por empresas, sem a garantia de confidencialidade que existe no consultório.As informações podem ser armazenadas, servir para treinamento ou, pior de tudo, vazar.

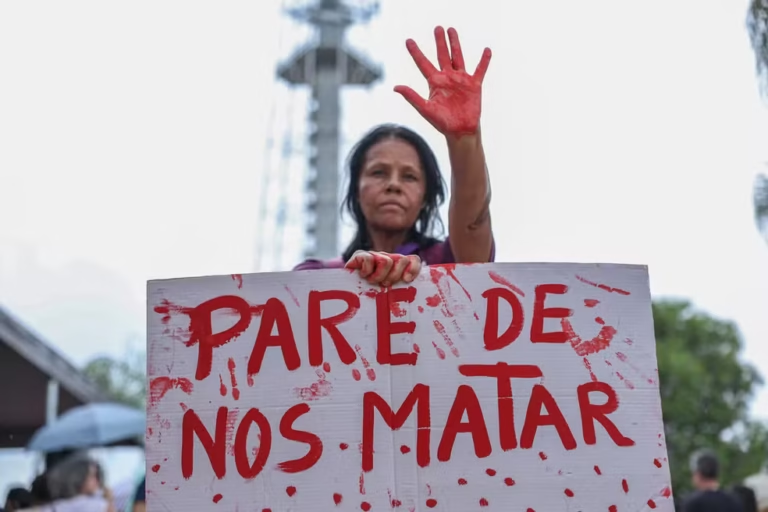

Em situações críticas, como ideação suicida, automutilação ou traumas profundos, a IA não possui discernimento nem sensibilidade para falar.